Ответы на курс: Основы теории информации и криптографии

Древовидные коды также называют:

Имеется (8,9)-код с проверкой четности. Вычислить вероятность ошибочной передачи без использования кода, если вероятность ошибки при передаче каждого бита равна 0.1%:

Вычислить минимальную и максимальную оценки количества дополнительных разрядов r для кодовых слов длины n, если требуется, чтобы минимальное расстояние между ними было d. Рассмотреть случаи n = 32, d = 3 и n = 23, d = 7:

Весом двоичного слова a=a1 … a_n называется:

Преимущество матричного кодирования заключается в:

Имеется (8,9)-код с проверкой четности. Вычислить вероятность того, что в случае ошибки этот код ее не обнаружит, если вероятность ошибки при передаче каждого бита равна 0.1%:

Коды с обнаружением ошибок предназначены для:

Неравенством Варшамова — Гильберта называют выражение:

Блочный код заменяет:

Следующее утверждение верно:

Вычислить минимальную оценку по Плоткину количества дополнительных разрядов r для кодовых слов матричного кода, если требуется, чтобы минимальное расстояние между ними было d. Рассмотреть случаи n = 32, d = 3 и n = 23, d = 7:

Расстоянием (Хэмминга) между двоичными словами длины n называется:

Последовательные коды характеризуются тем, что:

Простой код с обнаружением ошибок основан на:

Имеется (8,9)-код с проверкой четности. Вычислить вероятность того, что в случае ошибки этот код ее не обнаружит, если вероятность ошибки при передаче каждого бита равна 1%:

Коды с исправлением ошибок предназначены для:

Имеется (8,9)-код с проверкой четности. Вычислить вероятность ошибочной передачи без использования кода, если вероятность ошибки при передаче каждого бита равна 1%:

Если код является групповым, то:

Код Хэмминга:

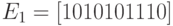

Для кодирующей матрицы  найти минимальное расстояние между словами кода:

найти минимальное расстояние между словами кода:

Для кодирующей матрицы  найти вероятность правильной передачи:

найти вероятность правильной передачи:

Блочный код называется групповым, если:

Двоичный блочный (m,n)-код называется оптимальным, если:

Для кодирующей матрицы  найти вероятность правильной передачи:

найти вероятность правильной передачи:

Принадлежат ли коду Голея кодовое слово 10000101011111010011111:

Построить кодовые слова квазисовершенного (9,n)-кода, исправляющего однократные ошибки, для тех сообщений, которые соответствуют числам 55, 200 и декодировать слова 1000001000001, 1100010111100, полученные по каналу связи, использующему этот код:

Для кодирующей матрицы  построить (3,4)-код:

построить (3,4)-код:

Для кодирующей матрицы  найти вероятность необнаружения ошибки:

найти вероятность необнаружения ошибки:

При полиномиальном кодировании каждое сообщение:

Многочлен g(x) степени k называется примитивным, если:

Коды Хэмминга являются:

CRC-коды способны обнаруживать:

Построить CRC-4 код для сообщения 10000000, используя полином-генератор x4+1:

Первый БЧХ-код, примененный на практике, был:

Для кода CRC-32 полином-генератор имеет степень:

Вычисление значения кода CRC происходит посредством:

Построить CRC-4 код для сообщения 10000000, используя полином-генератор x4+1:

Код Голея — это:

При реальной передаче или хранении информации ошибки:

Коды Рида-Соломона являются:

Найти кодирующий многочлен БЧХ-кода g(x) с длиной кодовых слов 15 и минимальным расстоянием между кодовыми словами 7. Использовать примитивный многочлен m1(x)=1+x+x4 с корнем  . Проверить, будут ли

. Проверить, будут ли  и

и  корнями соответственно многочленов m3(x)=1+x+x2+x3+x4 и m5(x)=1+x+x2:

корнями соответственно многочленов m3(x)=1+x+x2+x3+x4 и m5(x)=1+x+x2:

Алгоритм DES предназначен для шифровки:

Первая и наиболее известная система с открытым ключом называется:

Простейшая система шифрования основана на том, что:

Особенностью системы с ключевым словом является:

Между абонентами A и B установлен секретный канал связи без передачи ключей при заданных p=167 и их первых ключах 15 и 21. Описать процесс передачи сообщения 22 (от A к B):

Между абонентами A и B установлен секретный канал связи без передачи ключей при заданных p=167 и их первых ключах 15 и 21. Описать процесс передачи сообщения 17 (от B к A):

Нужно послать секретные сообщения 25 и 2 для JB и 14 для CIA, используя следующие записи открытой книги паролей криптосистемы RSA — JB: 77,7;

CIA: 667,15

Системы с ключевым словом характеризуются тем, что:

Зашифровать сообщение «КИБЕРНЕТИКА» ключом «ДИСК»:

Пользователь системы RSA выбрал p1=11 и p2=47. Некоторые числа из 12, 33, 125, 513 он может выбрать для открытого ключа. Вычислить для них закрытый ключ:

Шифры простой замены:

Разметка текста позволяет:

Для печати документа на принтере или показе на экране используется:

HTML представляет собой:

Большинство тегов языка HTML:

Тег IMG позволяет:

Компьютерный шрифт представляет собой:

При физической разметке точно указывается:

Специальные символы можно ввести в документ, используя их имена, заключенные между:

Самым распространенным типом данных в компьютерном мире является:

TeX представляет собой:

TeX популярен:

Бит определяет информацию:

АВМ служит для:

Основной категорией кибернетики является:

Аналоговая информация характеризуется:

Устройства для преобразования непрерывной информации в дискретную называются:

Кибернетика — это наука:

Частота дискретизации определяет:

Чем выше частота дискретизации, тем:

Теория информации изучает:

Программа для АВМ представляет собой:

Сущность принципа управления заключается в том, что:

Теория информации представляет собой:

При формальном представлении информации:

Информация может быть нескольких типов:

Чем ниже частота дискретизации, тем:

Предметом исследования кибернетики являются:

Устройства для преобразования дискретной информации в аналоговую называются:

Суть теоремы о выборках заключается в том, что:

В таблице кодировки ASCII+ печатные и управляющие символы занимают:

Дискретные случайные величины X1 и X2 определяются подбрасыванием двух идеальных тетраэдров, грани которых помечены числами от 1 до 4. Вычислить HX1.

Дискретные случайные величины X1 и X2 определяются подбрасыванием двух идеальных тетраэдров, грани которых помечены числами от 1 до 4. Дискретная случайная величина Y равна сумме чисел, выпавших при подбрасывании этих тетраэдров, т.е. Y=X1+X2. Вычислить HY:

Информация — это:

Общая схема передачи информации имеет вид:

Если непрерывные случайные величины X, Y заданы плотностями распределения вероятностей pX(t1), pY(t2) и pXY(t1,t2), то количество информации, содержащейся в X относительно Y равно:

Известно что  . Для каждого i pij равно либо qj, либо 0 при условии:

. Для каждого i pij равно либо qj, либо 0 при условии:

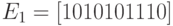

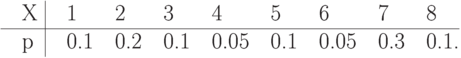

Найти энтропию дискретной случайной величины X, заданной распределением

Определить HZ, если задана дискретная случайная величина Z=(X1+1)2-X2, где независимые дискретные случайные величины X1, X2 могут с равной вероятностью принимать значение либо 0, либо 1:

Дискретная случайная величина X равна количеству «гербов», выпавших на двух идеальных монетках. Найти энтропию X:

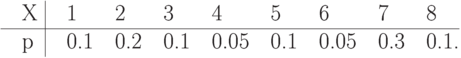

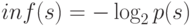

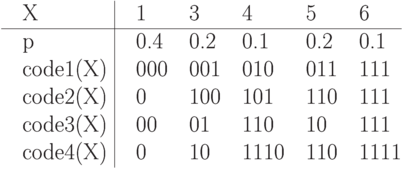

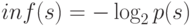

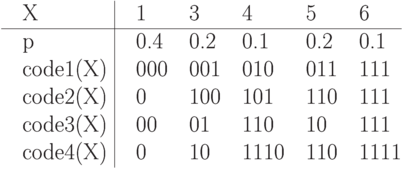

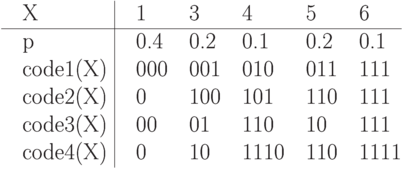

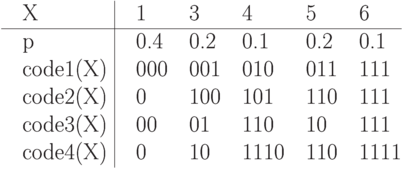

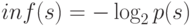

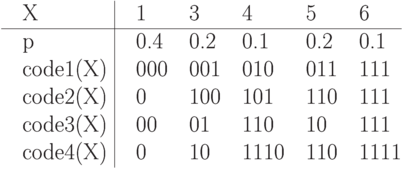

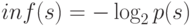

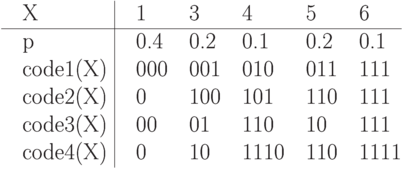

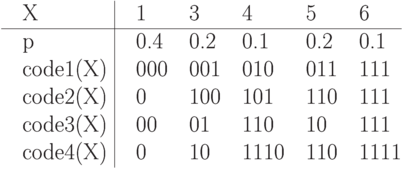

Найти среднюю длину code2 для дискретной случайной величины X:

Найти среднюю длину code2 для дискретной случайной величины X:

По теории Шеннона:

Префиксным называется кодирование:

Вычислить  предложения s1, про которое известно, что оно достоверно на 50%, и предложения s2, достоверность которого 25%:

предложения s1, про которое известно, что оно достоверно на 50%, и предложения s2, достоверность которого 25%:

Если задана функция  , где s-это предложение, смысловое содержание которого измеряется, p(s) — вероятность истинности s, то если

, где s-это предложение, смысловое содержание которого измеряется, p(s) — вероятность истинности s, то если  :

:

Найти среднюю длину code1 для дискретной случайной величины X:

Найти среднюю длину code1 для дискретной случайной величины X:

Энтропия дискретной случайной величины представляет собой:

Перед испытуемым человеком зажигается одна из N лампочек, которую он должен указать. Проводится большая серия испытаний, в которых каждая лампочка зажигается с определенной вероятностью pi, где i — это номер лампочки. Среднее время, необходимое для правильного ответа испытуемого, пропорционально:

Если задана функция  , где s-это предложение, смысловое содержание которого измеряется, p(s) — вероятность истинности s, то эта функция обладает свойствами:

, где s-это предложение, смысловое содержание которого измеряется, p(s) — вероятность истинности s, то эта функция обладает свойствами:

Дискретная случайная величина X задана распределением P(X=2n)=1/2n, n=1,2,…, Найти энтропию X:

Найти среднюю длину code4 для дискретной случайной величины X:

Найти среднюю длину code4 для дискретной случайной величины X:

Про дискретную случайную величину X известно, что ее значениями являются буквы кириллицы. Произведен ряд последовательных измерений X, результат которых — «ТЕОРИЯИНФОРМАЦИИ». Составить на основании этого результата приблизительный закон распределения вероятностей этой дискретной случайной величины и оценить минимальную среднюю длину кодов для X:

Цель сжатия состоит в:

Вычислить ML1(X) для блочного кода Хаффмена для X. Длина блока — 2 бита:

Вычислить ML1(X) для блочного кода Хаффмена для X. Длина блока — 2 бита:

Метод Шеннона-Фэно состоит в том, что:

Среднее количество бит, приходящихся на одно кодируемое значение дискретной случайной величины:

Выбрать верные утверждения:

Суть основной теоремы о кодировании при отсутствии помех заключается в том, что:

Максимально плотно сжимает метод:

Размер сжатия:

По методу Хаффмена код строится:

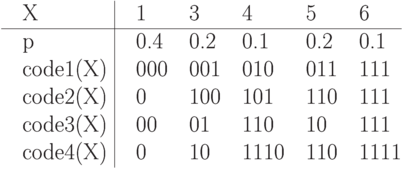

Вычислить ML(X) для кода Хаффмена для X. Дискретная случайная величина X задается следующим распределением вероятностей  :

:

Вычислить HX для кодов Хаффмена и Шеннона-Фэно для X. Дискретная случайная величина X задается следующим распределением вероятностей  :

:

Кодирование, основанное на основной теореме о кодировании при отсутствии помех:

Вычислить ML(X) для кода Шеннона-Фэно для X. Дискретная случайная величина X задается следующим распределением вероятностей  :

:

Вместе с собственно сообщением нужно передавать таблицу кодов для метода:

Преимущество арифметического кодирования позволяет:

Закодировать сообщение «КИБЕРНЕТИКИ», используя адаптивный алгоритм Хаффмена с упорядоченным деревом:

Составить арифметический код для сообщения BAABC, полученного от дискретной случайной величины X со следующим распределением вероятностей P(X=A)=1/4, P(X=B)=1/2, P(X=C)=1/4:

Вычислить длины в битах сообщения «AABCDAACCCCDBB» в коде ASCII+ и его полученного кода

Считая, что код генерируется дискретной случайной величиной X с распределением P(X=A)=2/3, P(X=B)=1/3 вычислить длины кодов Хаффмена, блочного Хаффмена (для блоков длины 2 и 3) для сообщения ABAAAB:

Закодировать сообщение BBCBBC, используя адаптивный алгоритм Хаффмена с упорядоченным деревом:

Вычислить длины в битах сообщения «КИБЕРНЕТИКИ» в коде ASCII+ и его полученного кода

Cообщение, полученное путем сжатия адаптивным алгоритмом Хаффмена с упорядоченным деревом имеет вид: ‘A’0’F’00’X’0111110101011011110100101. Определить длину несжатого сообщения в битах:

Составить арифметический код для сообщения BAABC, полученного от дискретной случайной величины X со следующим распределением вероятностей P(X=A)=1/3, P(X=B)=7/15, P(X=C)=1/5:

Дискретная случайная величина X может принимать три различных значения. Если считать сложность построения кода пропорциональной количеству различных значений кодируемой дискретной случайной величины, то блочный код для X по сравнению с неблочным сложнее строить в:

Закодировать сообщение «AABCDAACCCCDBB», используя адаптивный алгоритм Хаффмена с упорядоченным деревом:

Словарные алгоритмы преимущественно отличаются от статистических тем, что:

Алгоритм LZ77 выдает коды, состоящие из:

Закодировать сообщения «AABCDAACCCCDBB», вычислить длины в битах полученных кодов, используя алгоритм LZ78 (словарь — 16 фраз):

Закодировать сообщения «КИБЕРНЕТИКИ», вычислить длины в битах полученных кодов, используя алгоритм LZW (словарь — ASCII+ и 16 фраз):

Закодировать сообщения «СИНЯЯ СИНЕВА СИНИ», вычислить длины в битах полученных кодов, используя алгоритм LZW (словарь — ASCII+ и 16 фраз):

Закодировать сообщения «КИБЕРНЕТИКИ», вычислить длины в битах полученных кодов, используя алгоритм LZSS (словарь — 12 байт, буфер — 4 байта):

Алгоритм LZ77 использует «скользящее» по сообщению окно, разделенное на две части, выполняющие определенные функции:

«Скользящее» окно НЕ использует алгоритм:

Закодировать сообщения «СИНЯЯ СИНЕВА СИНИ», вычислить длины в битах полученных кодов, используя алгоритм LZ77 (словарь — 12 байт, буфер — 4 байта):

Статистическими методами называют:

Основная идея LZ77 состоит в том, что:

Код, выдаваемый LZSS, начинается с:

При чрезмерном увеличении размера словаря и буфера для алгоритмов LZ77 и LZSS, то это приведет:

Закодировать сообщения «AABCDAACCCCDBB», вычислить длины в битах полученных кодов, используя алгоритм LZ77 (словарь — 12 байт, буфер — 4 байта):

Алгоритм LZSS отличается от LZ77 следующим:

Популярность алгоритмов LZ обусловлена:

Запатентованным является алгоритм:

LZ77 и LZSS обладают следующими очевидными недостатками:

Эффективность канала характеризуется:

Сжатие с потерями обычно проходит в:

Основная идея сжатия графической информации с потерями заключается в том, что:

Канал информационный представляет собой:

Задержка сигнала во времени представляет собой:

Простейший код, исправляющий ошибки представляет собой:

Сжатие видеоинформации основано на том, что:

По каналу связи без шума могут передаваться четыре сигнала длительностью 1 мс каждый. Вычислить емкость такого канала:

Стандарт LPC используется для:

Видеоинформацию можно сжать:

Устройства канала связи представляют собой:

Cжатие с потерями позволяет:

Простейший код для борьбы с шумом представляет собой:

Для сжатия графической информации с потерями в конце 80-х установлен стандарт:

Сжатие с потерями используется в основном для видов данных:

Специальные таблицы для перевода неформальных данных в цифровой вид называются:

Противоположность информации:

Функция f-инъекция, если:

Клод Шеннон предложил способ изменения количества информации:

Кодирование представляет собой:

Значения дискретной случайной величины X1 и X2 определяются подбрасыванием двух идеальных монет, а дискретная случайная величина Y равна сумме количества «гербов», выпавших при подбрасывании этих монет. В Y содержится:

Определить характер зависимости между X1 и Z, если задана дискретная случайная величина Z=(X1+1)2-X2, где независимые дискретные случайные величины X1, X2 могут с равной вероятностью принимать значение либо 0, либо 1:

Определить HX1, если задана дискретная случайная величина Z=(X1+1)2-X_2, где независимые дискретные случайные величины X1, X_2 могут с равной вероятностью принимать значение либо 0, либо 1:

Найти среднюю длину code3 для дискретной случайной величины X:

Найти среднюю длину code3 для дискретной случайной величины X:

Считая, что код генерируется дискретной случайной величиной X с распределением P(X=A)=2/3, P(X=B)=1/3 вычислить длину арифметического кода для сообщения ABAAAB:

Распаковать сообщение ‘A’0’F’00’X’0111110101011011110100101, полученное по адаптивному алгоритму Хаффмена с упорядоченным деревом

Дискретная случайная величина X может принимать три различных значения. При построении блочного кода с длиной блока 4 для X необходимо будет рассмотреть дискретную случайную величину X — выборку четырех значений X. X может иметь:

Закодировать сообщение «СИНЯЯ СИНЕВА СИНИ», используя адаптивный алгоритм Хаффмена с упорядоченным деревом:

При кодировании методом Хаффмена и на 0 и на 1 придется тратить:

Вычислить длины в битах сообщения «СИНЯЯ СИНЕВА СИНИ» в коде ASCII+ и его полученного кода

Передатчик задается случайной величиной со следующими законами распределениями вероятностей: P(X2=-1)=1/3, P(X2=0)=1/3, P(X_2=1)=1/3. Емкость канала связи с шумом равна 4000 бод. Вычислить максимальную скорость передачи данных по этому каналу передатчиком, обеспечивающую сколь угодно высокую надежность передачи:

Для кодирующей матрицы  найти вероятность необнаружения ошибки:

найти вероятность необнаружения ошибки:

Для кодирующей матрицы  построить (2,5)-код:

построить (2,5)-код:

Для кода CRC-16 полином-генератор имеет степень:

Циклический избыточный код имеет:

Элементы SGML делятся на категории:

Преимущество формата PostScript заключается в том, что:

При логической разметке указывается:

Атрибут ALT тега IMG используется для:

PostScript представляет собой:

Вычислить  предложения

предложения  , про которое известно, что оно достоверно на 50%, и предложения

, про которое известно, что оно достоверно на 50%, и предложения  , достоверность которого 25%:

, достоверность которого 25%:

Составить адаптивный арифметический код с маркером конца для сообщения BAABC:

Принадлежат ли коду Голея кодовое слово 11000111011110010011111:

Наиболее широкое распространение получил:

ЦВМ служит для:

Укажите свойства меры информации и энтропии:

Передатчик задается случайной величиной со следующими законами распределениями вероятностей: P(X1=-1)=1/4, P(X1=0)=1/2, P(X1=1)=1/4. Емкость канала связи с шумом равна 4000 бод. Вычислить максимальную скорость передачи данных по этому каналу передатчиком, обеспечивающую сколь угодно высокую надежность передачи:

Совершенным является:

Свойства совершенного кода могут быть представлены в виде:

Для кодирующей матрицы  найти минимальное расстояние между словами кода:

найти минимальное расстояние между словами кода:

Криптография определяет:

Нераскрываемый шифр характеризуется тем, что:

найти минимальное расстояние между словами кода:

найти минимальное расстояние между словами кода: найти вероятность правильной передачи:

найти вероятность правильной передачи: найти вероятность правильной передачи:

найти вероятность правильной передачи: построить (3,4)-код:

построить (3,4)-код: найти вероятность необнаружения ошибки:

найти вероятность необнаружения ошибки: . Проверить, будут ли

. Проверить, будут ли  и

и  корнями соответственно многочленов m3(x)=1+x+x2+x3+x4 и m5(x)=1+x+x2:

корнями соответственно многочленов m3(x)=1+x+x2+x3+x4 и m5(x)=1+x+x2: . Для каждого i pij равно либо qj, либо 0 при условии:

. Для каждого i pij равно либо qj, либо 0 при условии:

Найти среднюю длину code2 для дискретной случайной величины X:

Найти среднюю длину code2 для дискретной случайной величины X: предложения s1, про которое известно, что оно достоверно на 50%, и предложения s2, достоверность которого 25%:

предложения s1, про которое известно, что оно достоверно на 50%, и предложения s2, достоверность которого 25%: , где s-это предложение, смысловое содержание которого измеряется, p(s) — вероятность истинности s, то если

, где s-это предложение, смысловое содержание которого измеряется, p(s) — вероятность истинности s, то если  :

: Найти среднюю длину code1 для дискретной случайной величины X:

Найти среднюю длину code1 для дискретной случайной величины X: , где s-это предложение, смысловое содержание которого измеряется, p(s) — вероятность истинности s, то эта функция обладает свойствами:

, где s-это предложение, смысловое содержание которого измеряется, p(s) — вероятность истинности s, то эта функция обладает свойствами: Найти среднюю длину code4 для дискретной случайной величины X:

Найти среднюю длину code4 для дискретной случайной величины X: Вычислить ML1(X) для блочного кода Хаффмена для X. Длина блока — 2 бита:

Вычислить ML1(X) для блочного кода Хаффмена для X. Длина блока — 2 бита: :

: :

: :

: Найти среднюю длину code3 для дискретной случайной величины X:

Найти среднюю длину code3 для дискретной случайной величины X: найти вероятность необнаружения ошибки:

найти вероятность необнаружения ошибки: построить (2,5)-код:

построить (2,5)-код: предложения

предложения  , про которое известно, что оно достоверно на 50%, и предложения

, про которое известно, что оно достоверно на 50%, и предложения  , достоверность которого 25%:

, достоверность которого 25%: найти минимальное расстояние между словами кода:

найти минимальное расстояние между словами кода: